实验室学生NLPCC2019参会汇报

发布人:罗倩

发布日期:2019-11-07

CCF国际自然语言处理与中文计算会议(NLPCC)于2019年10月9日至10月14日在中国敦煌举办。在中国计算机学会的国际学术会议推荐中,NLPCC是人工智能领域的C类会议。

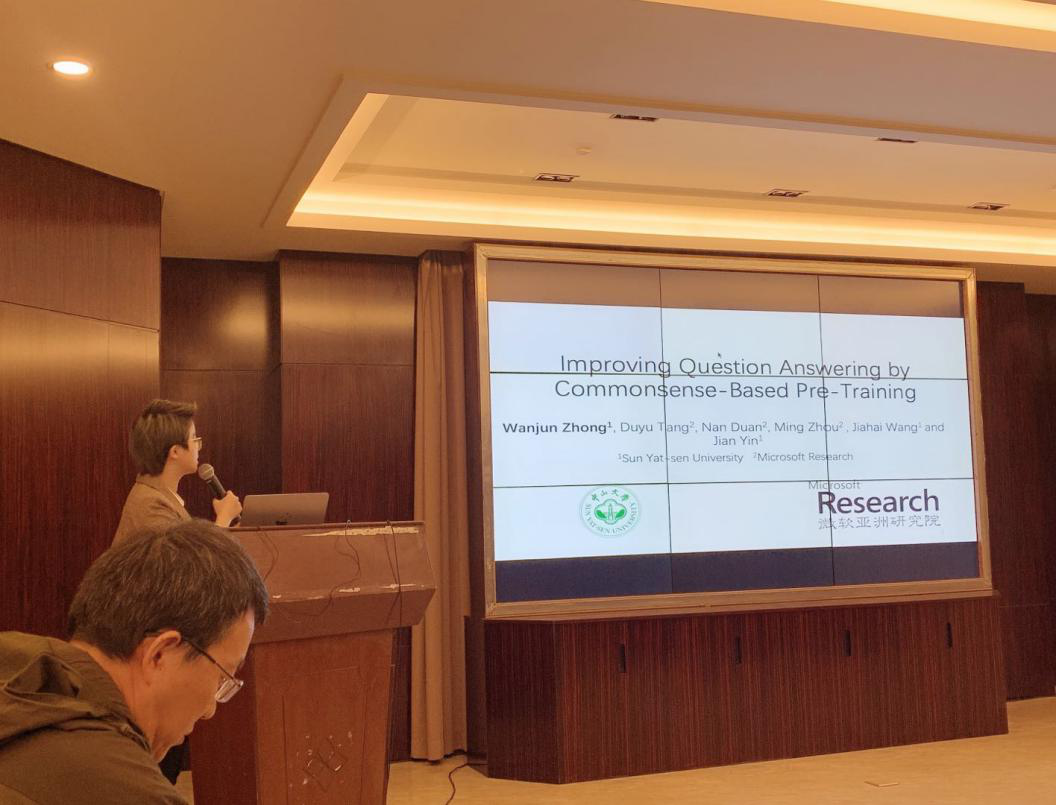

在此次会议中,实验室2018级博士生钟宛君以论文第一作者撰写的论文 “Improving Qestion Aswering by Commonsense-Based Pre-Training“有幸被会议接收。

论文主要关注的任务是需要常识知识的自然语言文本问答。而论文的主要内容则是:尽管基于神经网络类的方法在很多自然语言处理任务上取得了很好的效果。但是很多这类方法依然很难回答需要常识知识才能解答的问题。我们认为这种现象的主要原因是以前的方法没有建模常识概念间的联系。因此,我们提出了一种简单有效的方法,它利用了外部常识知识库,比如ConceptNet。我们预训练了基于直接关联和间接关联的关系建模模型。这个模型可以被很容易的加入到现有的神经网络方法中。结果证明加入了基于常识的方法提升了在三个基于常识的文本问答数据集上的性能。更多的分析证明了我们的系统找到并且利用了从外部常识知识库抽取出来的知识。这些知识在现存的神经网络方法中是没有被有效建模的。

参会感想:

NLPCC 2019大会内容主要围绕自然语言处理(NLP)和中文计算(CC)两方面来进行,包括多个技术评测、学科前沿讲习班(ADL)、主会等活动,吸引了来自国内外学界、研究所、企业等近千人参会。这一次参会,给我的最大感受就是现在学界关注的方向主要集中在文本推理和模型预训练上面。并且产业界也开始广泛应用人工智能的前沿技术。技术的更新迭代也很快。我们要加快研究进展,跟上前沿技术的进步。并且时刻关注学界动态。